Forum

Pipeline com _PROCESSING_TIMESTAMP sempre igual em pipeline Incremental

Tenho uma pipeline incremental no Dadosfera tech que pega dados de um bucket no S3 e adiciona um arquivo novo por dia na tabela da Dadosfera.

Como é só um arquivo novo por dia, o comportamento esperado é que a tabela desta pipeline gerasse um `__PROCESSING_TIMESTAMP_` para cada dado novo. Contudo, todos os dados, até mesmo os antigos, ficam com o `__PROCESSING_TIMESTAMP_` mais atual.

Hoje é dia 13/03/24 e mesmo dados de fevereiro estão com o timestamp mais atual - e não houve modificação nestes arquivos.

Por que isso ocorre?

O id da pipeline em que isso está ocorrendo é: 85b7ab00-7f23-4020-b540-aad59b9bc8d2

Posted by Davi Ribeio about 1 month ago

Ambiente de demo não encontra env var

Estou tentando acrescentar uma variável de ambiente em um dataapp no módulo de inteligência. Porém, mesmo quando eu coloco a variável de ambiente no projeto, desligando e a sessão do dataapp, ele não reconhece as variáveis de ambiente.

Até rebuildei o projeto, mas não teve efeito.

Como posso resolver?

Posted by Luiz Yamada about 2 months ago

Conexão Snowflake no módulo de inteligência

Necessito de auxílio com o conector do snowflake. Apesar de não estar acusando erro ao gerar um arquivo ou variável ela não fica com a tabela, mas sim com a query escrita. Já chequei em outros projetos e não há diferença entre o step que estou utilizando (Copiado da stepsfera no ambiente demo) para esse outros projetos (em outros ambientes). Preciso dos dados da tabela no orchest para utilizar no data app em desenvolvimento.

Posted by Laura Novaes about 2 months ago

Problema para subir a dadosferalib

Ao tentar instalar a dadosferalib no environment 5d0bb273-5491-4ac4-a2a2-ba32282567fd utilizando o seguinte script:

# !/bin/bash

sudo apt-get update

sudo apt-get install gettext -y

chmod +x ./compile_translations

pip3 install pyOpenSSL --upgrade

pip3 install awscli chardet requests anybase32 pandas snowflake-snowpark-python snowflake

pip3 install streamlit

pip install geopy folium

pip install -r requirements.txt

aws codeartifact login --tool pip --domain dadosfera --domain-owner 611330257153 --region us-east-1 --repository dadosfera-pip

pip3 install dadosfera==1.5.0 dadosfera_logs==1.0.3

Estou obtendo como erro que a biblioteca não está sendo encontrada. Também tentei usando a imagem Custom: dadosfera/base-kernel-py:1.0.2 e obtive o mesmo erro.

### Traceback do erro

```Text shell

Traceback (most recent call last):

File "/project-dir/get_table_from_snowflake/get_table_from_snowflake.py", line 1, in <module>

from dadosfera.services.snowflake import get_snowpark_session

File "/project-dir/get_table_from_snowflake/dadosfera/services/snowflake.py", line 2, in <module>

import snowflake.connector

File "/opt/conda/lib/python3.9/site-packages/snowflake/connector/__init__.py", line 19, in <module>

from .connection import SnowflakeConnection

File "/opt/conda/lib/python3.9/site-packages/snowflake/connector/connection.py", line 33, in <module>

from . import errors, proxy

File "/opt/conda/lib/python3.9/site-packages/snowflake/connector/errors.py", line 18, in <module>

from .telemetry_oob import TelemetryService

File "/opt/conda/lib/python3.9/site-packages/snowflake/connector/telemetry_oob.py", line 22, in <module>

from .vendored import requests

File "/opt/conda/lib/python3.9/site-packages/snowflake/connector/vendored/requests/__init__.py", line 119, in <module>

from ..urllib3.contrib import pyopenssl

File "/opt/conda/lib/python3.9/site-packages/snowflake/connector/vendored/urllib3/contrib/pyopenssl.py", line 50, in <module>

import OpenSSL.crypto

File "/opt/conda/lib/python3.9/site-packages/OpenSSL/__init__.py", line 8, in <module>

from OpenSSL import SSL, crypto

File "/opt/conda/lib/python3.9/site-packages/OpenSSL/SSL.py", line 34, in <module>

from OpenSSL.crypto import (

File "/opt/conda/lib/python3.9/site-packages/OpenSSL/crypto.py", line 945, in <module>

utils.deprecated(

TypeError: deprecated() got an unexpected keyword argument 'name'

```

Posted by Laura Novaes 2 months ago

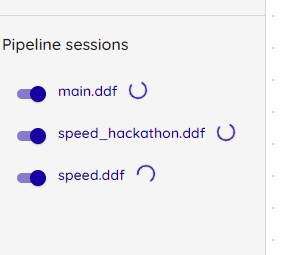

O carregamento da pipeline sessions não está acontecendo.

Posted by null 8 months ago

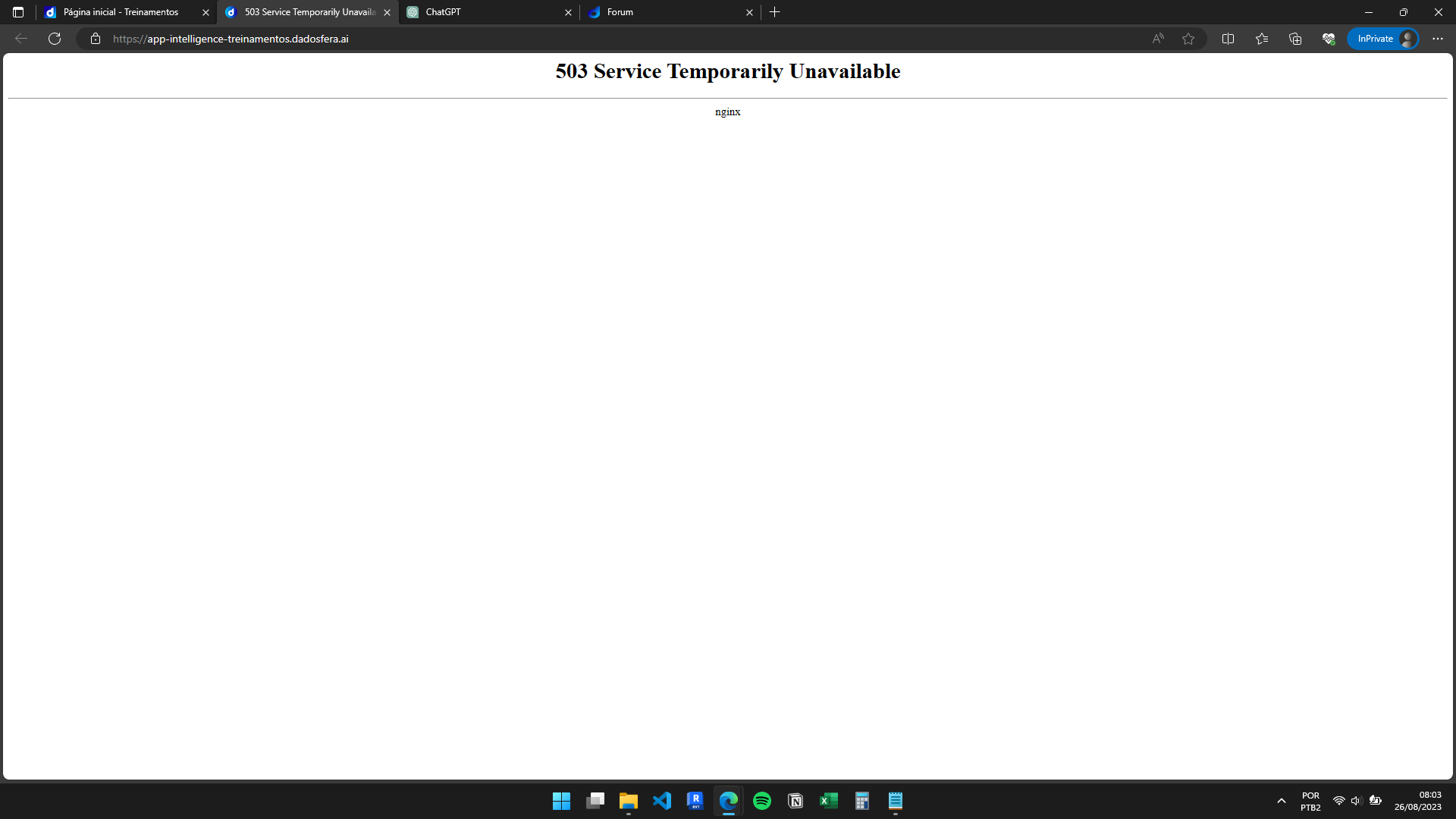

Sem acesso!

Olá, desde ontem estou enfrentando alguns problemas. Perdi acesso ao kernel e módulo de inteligência. Consegui resolver, porém, agora caiu o serviço. Não sei se é um problema específico da minha conta.

OBS: consigo acessar o ambiente dadosfera, somente o módulo de inteligência que ocorre esse erro!

Posted by felipe 8 months ago

Perdendo conexão com o kernel e ambiente de inteligência

A partir de sexta a tarde 25/08, comecei a perde a conexão com o kernel.

E hoje 26/08, até o enviado dessa mensagem, estou sem acesso ao ambiente de inteligência.

Posted by null 8 months ago

Upload dos pipelines no dirétório /data na camada de inteligência [Speed Hackathon IA Generativa]

Primeiro criei a conexão (importação unica), definir os pipelines, resultado foi que dados das planilhas não foram carregados, mas entendi que a tabulação sim foi compreendida já que não apareceu nenhum erro, então subir cada arquivo .csv no menu "importar arquivos" , assim foi automaticamente cada pipeline recebeu automaticamente os dados do respectivo arquivo .csv

Mas, tinha entendido que após os dados estiverem na pipeline automaticamente eles constaria em /data na camada de inteligência, perdi algo?

Até o momento subir manualmente os arquivos na camada de inteligência.

Posted by Diogo Almeida Marin 8 months ago

Estruturação do problema

Bom dia, tudo bom?

Tenho uma dúvida. Criei um notebook que analisa sentimento de clientes classificando como positivo ou negativo. Porém, na mesma base de dados não conseguirei gerar modelos que respondam as outras questões propostas: tendências de consumo devido a sazonalidade, por exemplo, uma vez que minha base não dispõe dessas informações. Pensei em utilizar várias bases (vários notebooks), tratando cada problema de forma individual, e posteriormente faria a união dessas informações. É possível fazer dessa forma? Ou orientam utilizar apenas uma base para extrair todas informações?

Posted by Felipe santana 8 months ago

Problemas com carregamento da sessão

Bom dia, o Pipeline sessions não está carregando e desta forma não consigo acesso um data apps rodando. O indicador de processamento da Pipeline sessions fica girando sem parar.

Posted by Carlos Eduardo Borges Falcone 8 months ago